近年来,随着云计算、5G、人工智能、物联网、AI等新技术的快速发展和应用,数据量规模成指数级增长,传统集中式存储方案因可靠性、安全性无法保障,数据利用率低等弊端,无法满足大规模的存储应用需求,在此背景下分布式存储应运而生。分布式存储凭借其易扩展、高性能、成本优势明显、支持分级存储、多副本一致性及存储系统标准化等优势成为云环境下存储底座构建的重要选择。

分布式存储分为块存储、文件存储和对象存储,其中块存储主要是对计算集群虚拟机、容器提供弹性卷服务,而弹性卷EVS作为当前云业务平台最核心的存储服务,对存储性能要求极高,在此基础上各大云厂商基本采用全闪化形态部署。固态硬盘(SSD)以闪存为存储介质,相比机械硬盘(HDD)具有读写速度快、延迟低、抗震性好等优势,在分布式存储中广泛使用。

Ceph是当前业界应用最广泛的开源分布式存储软件,具备高扩展性、高性能、高可靠等特点,同时支持块存储、文件存储及对象存储接口,已成熟应用于云计算的IAAS平台。为更好助力分布式块存储系统性能及可靠性的提升,忆联在Ceph平台下开展实测。

Ceph是一个统一的分布式存储系统,可提供较好性能、可靠性和可扩展性,是面向云计算领域重要的底层存储系统,已在国内运营商、政府、金融、互联网等多个行业落地应用。

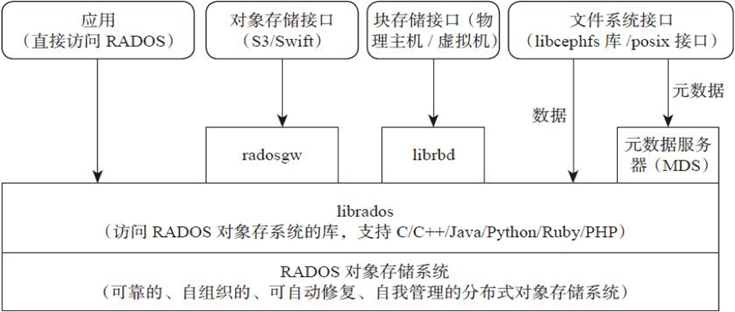

图1:Ceph技术架构图

Ceph主要分为应用接口层、存储基础接口层、存储对象层,接口层主要负责客户端访问,分为本地语言绑定接口、块存储设备接口和文件系统接口,展现了Ceph统一性的特征。

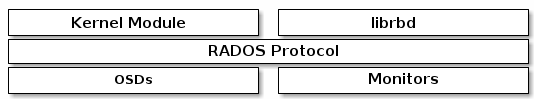

在Ceph块存储系统中,数据以块的形式存在卷里,块为应用程序提供大存储容量,可靠性和性能都更高,卷可映射到操作系统中,由文件系统层控制。Ceph块存储系统引入的RBD(Ceph块设备)协议为客户端提供了高可靠、高性能、分布式的块存储,同时RBD也支持其他的企业级特性,例如完整和增量式快照,精简的配置,写时复制( copy-on-write)式克隆,以及全内存式缓存等,从而大大提高了它的性能。

图2:Ceph块存储组件

1. 验证环境

1.1 本次验证硬件配置

类型

型号

硬件配置

服务器

2U2路服务器

CPU:Intel Xeon Gold 6336Y @2.4GHz

内存:12*16GB

存储控制器:支持RAID 1(系统盘)

网卡:2*2端口25GE以太网卡

硬盘

忆联SSD

系统盘:2*480GB SATA

数据盘:8*7.68 NVMe SSD(UH811a)

交换机

25GE 交换机

48端口25GE交换机

1.2本次验证软件配置

|

类型 |

型号 |

版本 |

|

操作系统 |

CentOS(x86) |

7.6 |

|

存储软件 |

Ceph(开源) |

12.2.8 luminous |

|

FIO |

IO测试 |

3.7 |

|

SAR |

网络监控 |

10.1.5 |

|

IOSTAT |

盘侧IO统计 |

10.0.0 |

|

MPSTAT |

CPU利用 |

10.1.5 |

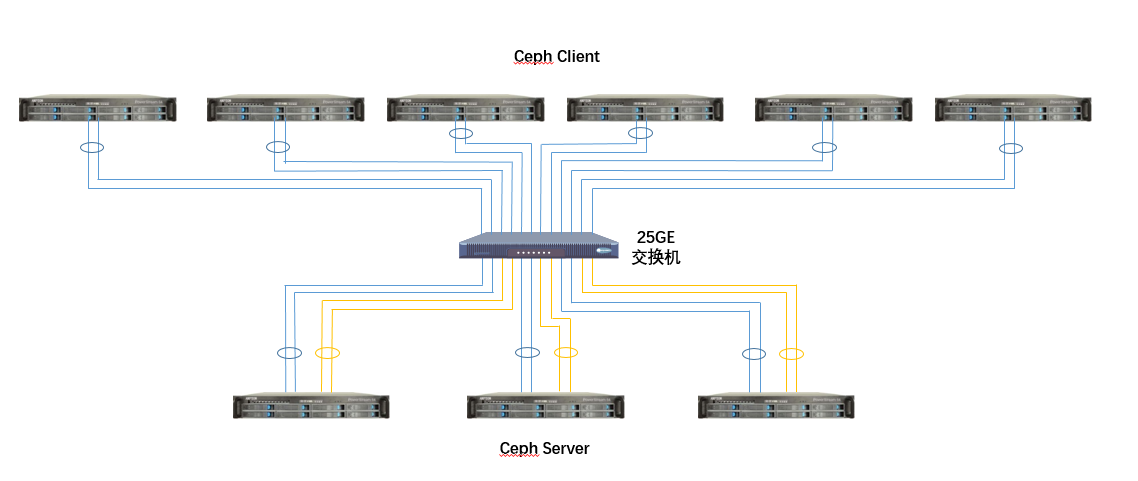

1.3本次验组网规划

图3:Ceph组网规划架构图

步骤1:创建RBD pool和RBD卷。配置参数osd_pool_default_size确定RBD Pool池的副本数,2表示两幅本,3表示三副本,根据实际副本数需求,将该配置项添加到ceph.conf中即可。另外根据规划,需要创建60个大小为100GiB的RBD卷进行IO测试。

步骤2:下发IO测试前,需对服务器和客户端的IO、CPU、网络进行监控,每2秒采集一次数据。

步骤3:在6个客户端上同时对60个RBD卷下发IO,每个客户端均需绑核,即每个fio绑定不同cpu核。

步骤4:完成IO测试后,需关闭服务端和客户端的IO、CPU、网络进行监控。

步骤5:测试完成后,需汇总所有客户端fio的BW、IOPS、平均时延,汇总对应的监控数据。对于BW和IOPS,累加各FIO对应结果即可;对于平均时延,累加之后需求平均值。

本次在 Ceph场景下验证结果(以下结果为本次测试结果,仅供参考)如下:

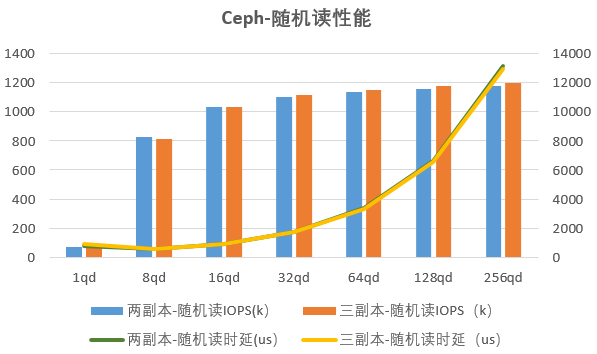

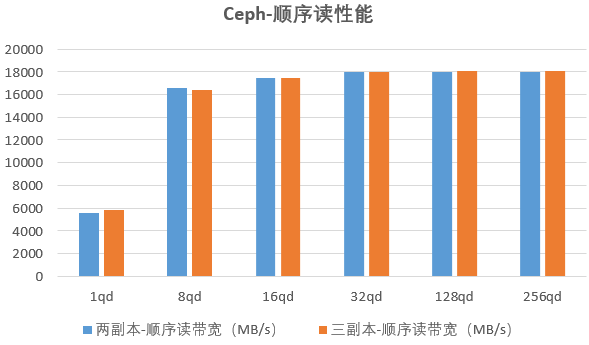

3.1忆联UH8系SSD在随机读及顺序读下的表现

图4:Ceph场景下忆联UH8系SSD读性能

从图4可以看出,在Ceph分布式存储系统下,不论是二副本还是三副本,忆联UH8系SSD的读性能基本持平。在时延方面,二副本与三副本趋势基本一致,1QD至32QD间较为稳定,在32QD后时延明显增加。

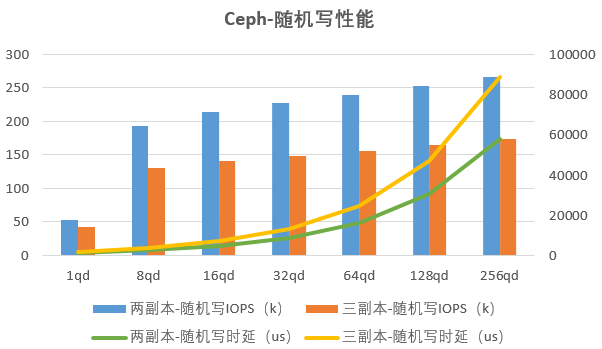

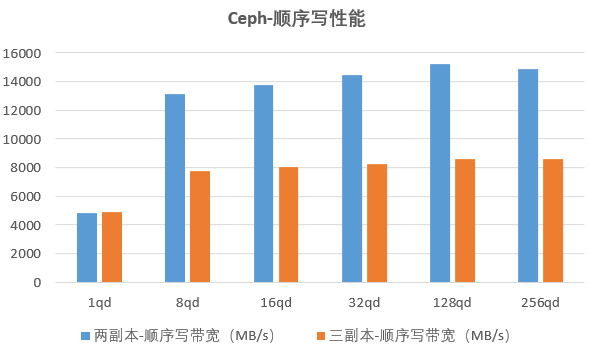

3.2忆联UH8系SSD在随机写及顺序写下的表现

图5:Ceph场景下忆联UH8系SSD写性能

如图5所示,不论是在随机写还是在顺序写业务下,二副本写性能远高于三副本性能,主要是由于副本复制带来的网络及存储开销,造成三副本写带宽及写IOPS下降明显。在总体时延表现上,二副本明显优于三副本。在时延变化趋势上,二副本与三副本基本一致,皆在32QD后有比较显著的上升。

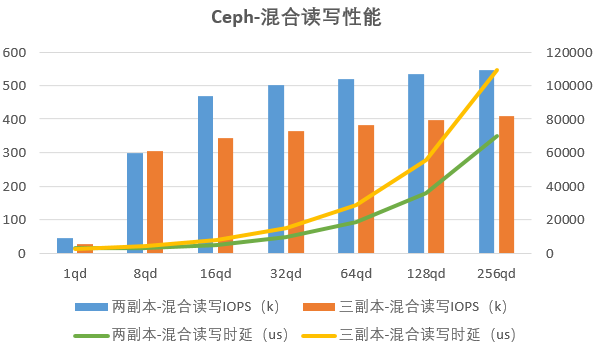

3.3忆联UH8系SSD在混合读写场景下的表现

图6:Ceph场景下忆联UH8系SSD混合读写性能

从图6可以看出,在4K 7:3混合读写业务场景下,从16QD起,二副本IOPS性能优于三副本。在时延整体表现上,二副本低于三副本,但在时延变化趋势上,二副本与三副本基本一致,时延从32QD起,明显上升。

结论:

从Ceph读、写、混合读写业务场景的实测数据中,可以看到忆联SSD整体表现优秀,可为Ceph环境提供极致存储性能。在时延上,忆联SSD在32QD及以下场景中,表现亮眼,可获得更佳的时延体验。

3.4 智能多流降WA,有效提升SSD寿命

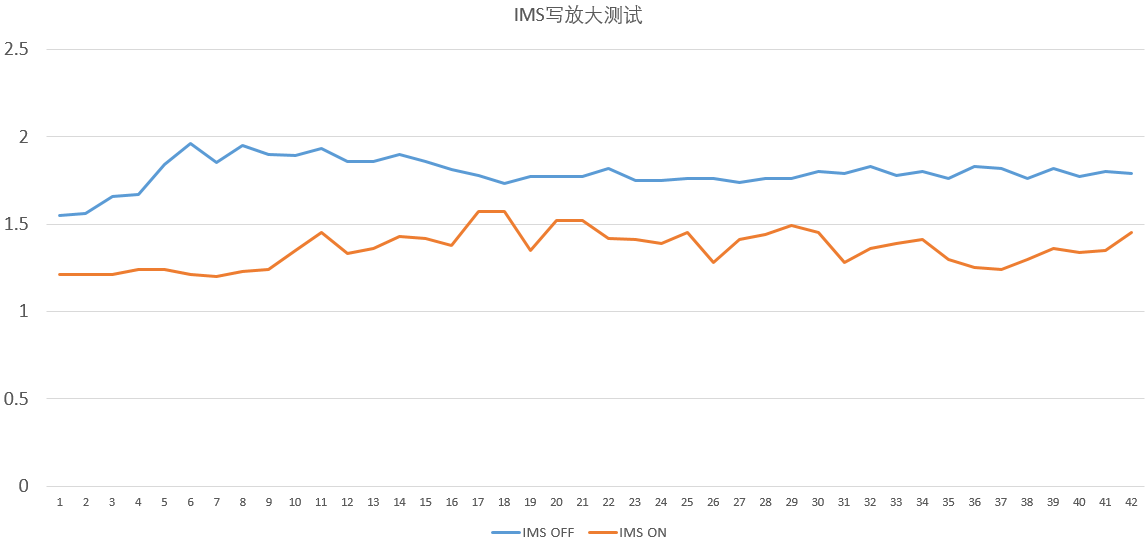

图7: Ceph场景下智能多流特性测试

图7: Ceph场景下智能多流特性测试

在Ceph方案中,基于标准JESD 219业务模型,针对SSD分别开启、关闭智能多流进行写放大测试,通过图7对比验证结果可以看到忆联智能多流(IMS)开启后,SSD写放大降低20%+,极大提升了SSD寿命。

本次验证清晰显示了忆联SSD 在Ceph分布式存储系统下性能的稳定发挥,有效地支撑了Ceph的存储需求,可提供始终如一的高性能,成为软件定义存储解决方案最优的选择。同时,忆联SSD独有的智能多流技术可降低分布式存储场景下SSD写放大,提升SSD寿命,帮助用户减少总体TCO。对于Ceph分布式存储系统而言,忆联SSD是一个可真正做到高性能、高可靠、低成本的存储解决方案。