1.验证环境

1.1 本次验证硬件配置

|

类型 |

型号 |

硬件配置 |

|

服务器 |

2U2路服务器 |

CPU:Intel Xeon Gold 6336Y @2.4GHz |

|

内存:12*16GB |

||

|

存储控制器:支持RAID 1(系统盘) |

||

|

网卡:2*2端口25GE以太网卡 |

||

|

硬盘 |

忆联SSD |

系统盘:2*480GB SATA 数据盘:1*7.68 NVMe SSD FW8023(UH711a) |

1.2 本次验证软件配置

|

类型 |

型号 |

版本 |

|

操作系统 |

CentOS(x86) |

7.6 |

|

磁盘压力工具 |

FIO |

3.18 |

|

磁盘维护工具 |

Umtool |

1.0.2.0-4 |

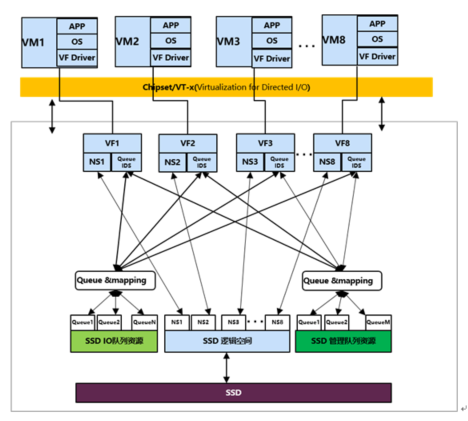

1.3 本次验证组网规划

2.验证方法

步骤1:安装部署KVM虚拟化环境,创建虚拟机并安装虚拟机操作系统;

步骤2:服务器配置1块UH711a,并创建8个VF 及NameSpace,并将NameSpace同VF绑定创建8个SR-IOV虚拟磁盘,再将8个虚拟磁盘挂载到8个 KVM 虚拟机上。

3.验证结果

本次在VF QoS场景下验证结果如下:

3.1 在对不同VF设置不同流量限制条件下,对QOS功能有效性的验证

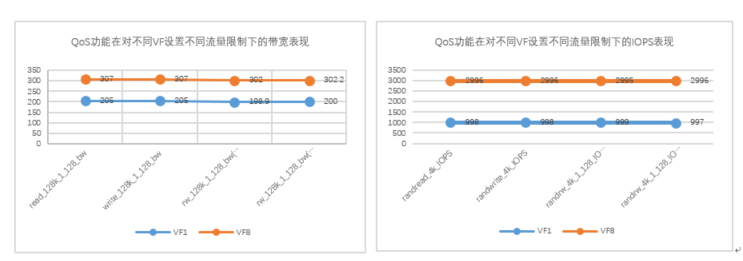

图2:QoS功能在对不同VF设置不同流量限制下的带宽及IOPS表现

对不同虚拟机下的VF1、VF8设置不同QoS,其中VF1和VF8的带宽峰值流量分别为200M、300M ,IOPS峰值流量分别为1000、3000。在虚拟机内部使用FIO工具进行性能测试,从图2测试结果可看到VF1和VF8在不同业务场景下性能得到了较好发挥,VF1及VF8的读写带宽及IOPS与峰值流量QoS最大相差不超过3% 。

由此可见,忆联UH7系SSD的QoS功能在对不同VF设置不同流量指标的场景中可保持性能稳定发挥。

3.2 在VF状态变化的条件下,对QOS功能有效性的验证

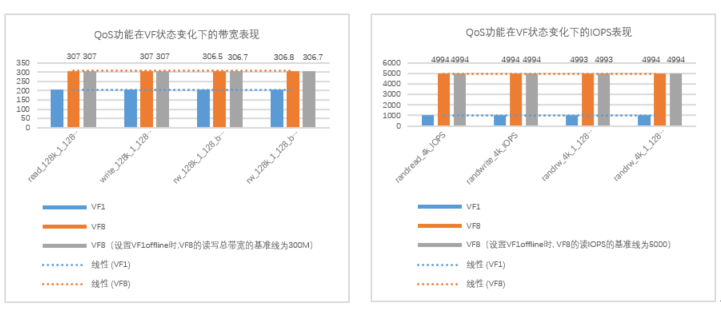

图3: QoS功能在VF状态变化下的带宽及IOPS表现

为更好验证VF状态变化对QoS功能有效性的影响,在本次测试环境下,对不同虚拟机下的VF进行不同的峰值流量设置,并对其中一个VF进行offline操作,以观察其他VF是否可达到设定的流量值,其中VF1、VF8带宽限制为200M、300M,VF1、VF8 IOPS限制为1000、5000。

从图3验证结果可见,在VF1 offline时,不管是在IOPS还是带宽上,VF8流量值都接近限制峰值,且在读、写、混合读写等场景下,不管是带宽还是IOPS都基本与VF1 offline之前的结果相近,明显验证了在忆联SR-IOV with QoS功能下的VF受到其他VF状态影响较小,VF间具有一定性能隔离。

3.3在对不同VF设置不同带宽的条件下,对QoS有效性的验证

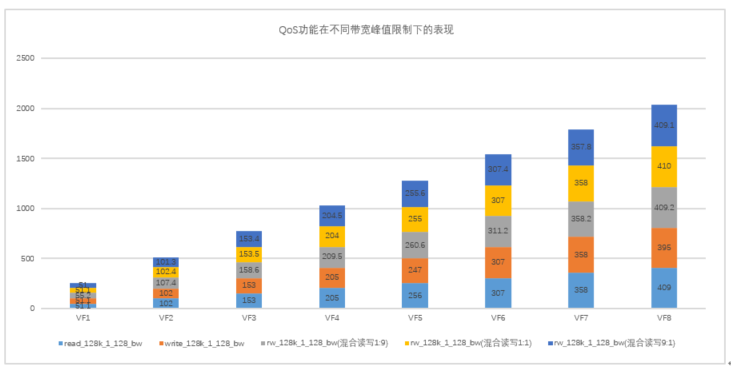

图4: QoS功能在不同带宽峰值限制下的表现

在本轮验证中,在相同环境下,对8个不同虚拟机下的VF设置不同的QoS,以观察不同虚拟机下的VF是否可达到设置的QoS值,其中VF1的带宽峰值为50M,VF2至VF8依次增加50M,VF8带宽峰值为400M。

通过测试发现,UH7系SSD在对所有VF进行不同带宽限制时,各VF带宽流量在不同场景下相差较小,每个VF都可较好执行QoS峰值设置,确保最佳使用体验。